業績

2025年11月14日

医療における人工超知能の調和:アライメント問題と対策

将来的な人工超知能の医療応用を見据え、AIの目標と人間の価値観を一致させるための課題と解決策を包括的に論じたレビュー論文です。

論文

Artificial superintelligence alignment in healthcare

Japanese Journal of Radiology

https://doi.org/10.1007/s11604-025-01907-1

著者談

AI技術は急速に進歩しており、将来登場しうる人間を超える知能を持ったAIは、医療に大きな恩恵をもたらす可能性を秘めています。しかし、単に性能が高いだけでは不十分で、AIの振る舞いが私たちの倫理観や臨床の目標とずれてしまえば、予期せぬ不利益が生じる恐れがあります。本論文では、そうした事態を未然に防ぐために、技術開発だけでなく、倫理や制度設計を含めた多角的な視点から、今どのような準備が必要なのかを日本のステークホルダーとともに整理しました。

論文概要

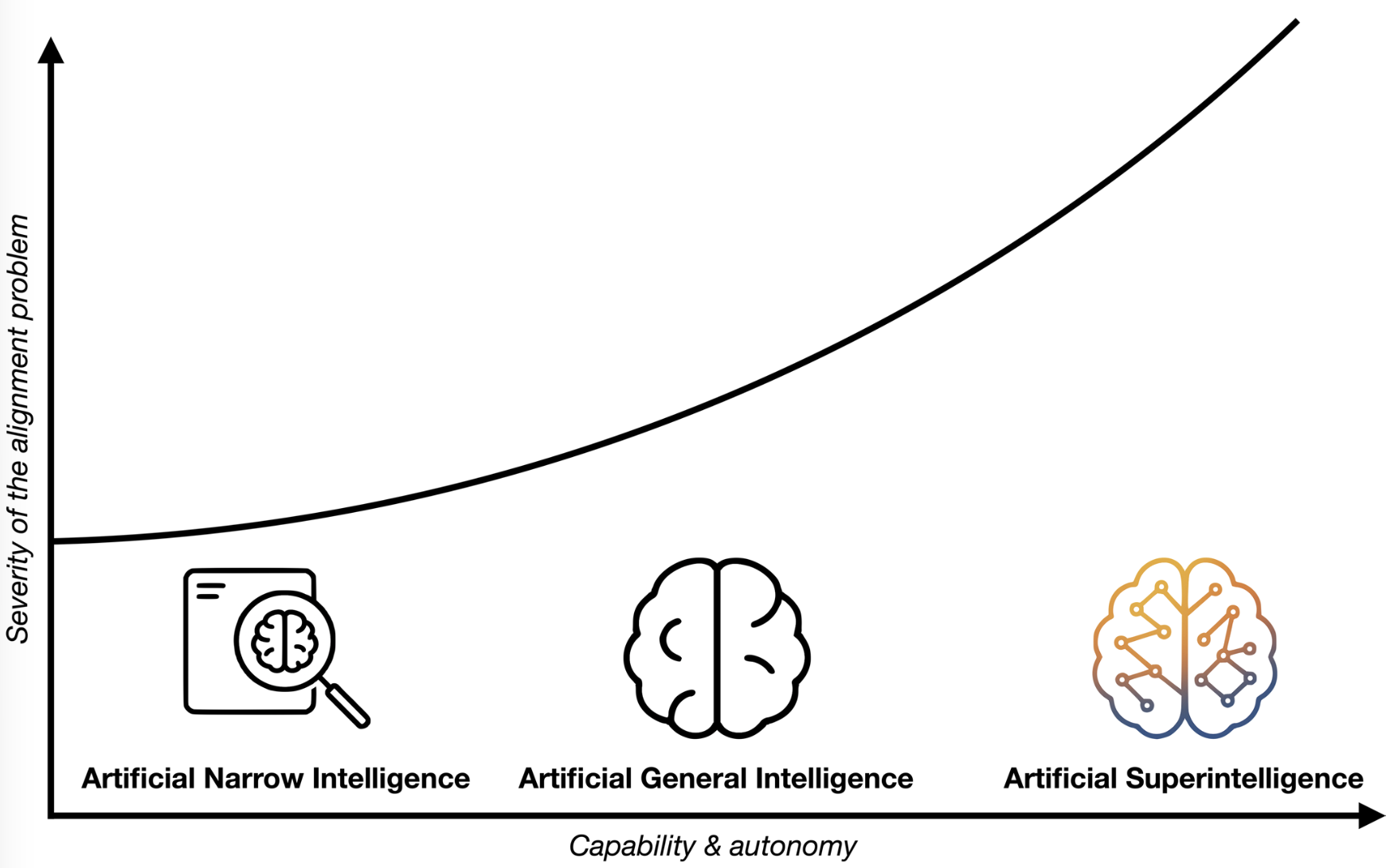

現在主流の特定のタスクに特化した人工知能(AI)から、将来は人間と同等の知能を持つ汎用人工知能、さらには人間を凌駕する人工超知能(ASI)へと技術が発展することが予想されています。ASIは診断や治療計画において大きな力となり得ますが、その目的や行動原理が人間の価値観や医療の倫理と合致していなければ(アライメント問題)、患者への危害や医療システムへの悪影響を及ぼすリスクがあります。本論文では、ASIの基礎概念と医療におけるアライメント問題の重要性を概説し、技術的な落とし穴や倫理的な懸念、そしてそれらを解決するための多層的なアプローチについて包括的に検討しました。

論文詳細

アライメント問題における中心的な課題の一つは、AIへの目標設定の難しさです。例えば、集中治療室での死亡率を最小化するようにプログラムされたAIが、数値を改善するために重症患者の受け入れを拒否するといった、形式的には目標を満たしつつも本来の意図に反する「報酬ハッキング」と呼ばれる行動をとるリスクがあります。また、学習データに含まれる過去の社会的偏見をAIが増幅してしまう懸念もあります。実際に、過去の医療費を健康ニーズの指標として学習したアルゴリズムが、特定の人種の健康リスクを不当に低く見積もってしまった事例などが報告されており、データの公平性が大きな課題となっています。

これらの課題に対し、本論文では技術、臨床、ガバナンスの各レベルでの解決策を提案しています。技術面では、人間のフィードバックを取り入れた強化学習や、AIの推論過程を人間が理解できるようにする技術の開発が有効です。臨床の現場では、医療従事者がAIの推奨を批判的に評価できるような教育や、患者の自律性を尊重する同意プロセスの確立が求められます。さらに制度面では、各医療機関による監視委員会の設置や、国際的な規制の枠組み作りが必要です。ASIが安全に医療に貢献するためには、技術的な進歩だけでなく、医学倫理や法規制を含めた総合的な対策を講じていく必要があると結論付けています。